Une IA qui voit, comprend et agit : les avancées du Centre de Robotique

Contrairement aux IAs grand public, souvent focalisées sur l’analyse a posteriori de données massives, les travaux du CAOR s’inscrivent dans une contrainte centrale : agir en situation, en interaction continue avec un environnement incertain. Les algorithmes doivent être rapides, robustes, si possible explicables, et capables de fonctionner avec des données parfois limitées. Cette approche irrigue l’ensemble des recherches du centre, depuis la perception de l’environnement jusqu’à la planification des actions, en passant par la compréhension fine des comportements humains.

Depuis plusieurs années, les chercheurs du CAOR explorent une idée contre-intuitive : percevoir la géométrie d’un espace grâce au son. Le projet Omni-Batvision s’inspire du principe d’écholocation utilisé par les chauves-souris. Un signal sonore est émis, ses échos sont captés par des microphones, puis transformés en spectrogrammes, des représentations visuelles du son. Grâce au deep-learning, ces spectrogrammes peuvent être traduits en images de profondeur, révélant la structure 3D d’un environnement, parfois même au-delà des obstacles visibles. Si le son seul reste moins précis que la vision, sa fusion avec les données visuelles améliore significativement la perception globale. À terme, ces travaux pourraient équiper des aides à la navigation pour les personnes malvoyantes ou renforcer la sécurité des robots mobiles dans des environnements complexes.

Autre piste originale : agir non pas seulement sur les algorithmes, mais sur le monde qu’ils observent. En collaboration avec Valeo, le CAOR développe des systèmes d’éclairage intelligent exploitant les phares à LED haute résolution. L’IA apprend à adapter dynamiquement le faisceau lumineux afin d’optimiser la détection d’objets ou la segmentation de la scène par vision artificielle. Concrètement, le système analyse une image de la route telle qu’elle est éclairée, puis propose une configuration lumineuse qui maximisera la qualité de perception. Grâce aux techniques d’apprentissage, la lumière devient un paramètre actif de la perception, et non plus un simple éclairage.

Vision d’un environnement à partir d’un robot du projet Omni-Batvision

La perception 3D est au cœur de la robotique moderne. Au CAOR, plusieurs travaux portent sur le deep-learning appliqué aux nuages de points 3D, une représentation graphique de données généralement nombreuses, issus notamment de capteurs lidar (télédétection par laser), une technique de mesure à distance fondée sur l’analyse des propriétés d’un faisceau de lumière généré artificiellement et renvoyé par la cible vers son émetteur. Ces données, très différentes des images classiques, nécessitent des opérations de convolution spécifiques. Les chercheurs développent ainsi de nouvelles méthodes permettant de distinguer automatiquement le sol, les murs, les objets ou les personnes dans un environnement tridimensionnel. Ces capacités sont essentielles pour la navigation autonome par exemple.

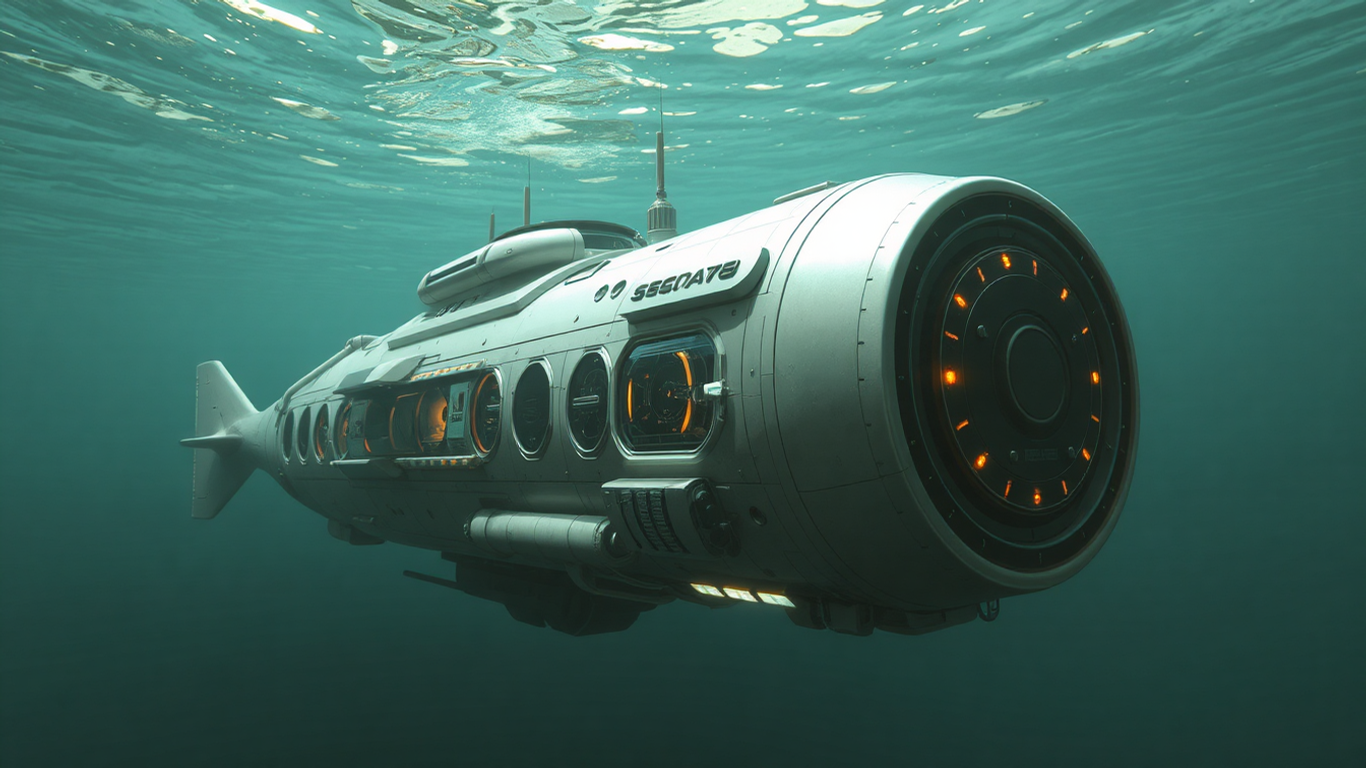

Le centre explore également les méthodes de modélisation implicite comme les Neural Radiance Fields (NeRF), qui permet de construire une représentation 3D à partir d’images en 2D, ou le Gaussian Splatting, une technique de rendu 3D à partir de plusieurs images. À partir d’un ensemble d’images et des positions de la caméra, ces modèles apprennent donc à reconstruire une scène complète et à générer de nouvelles vues. Un enjeu clé concerne le temps de calcul, longtemps incompatible avec des usages interactifs. Les travaux récents, notamment autour du rendu en réalité virtuelle, visent à accélérer drastiquement ces méthodes pour permettre un affichage fluide et réaliste. Les applications vont de la numérisation du patrimoine à la formation immersive, en passant par la robotique et la réalité augmentée.

Reconstitution d’une scène de bateau reposant sur les Neural Radiance Fields (NeRF)

Dans les environnements industriels ou artisanaux, les robots doivent comprendre ce que font les humains, et parfois l’anticiper dans le temps, en s’adaptant à leur rythme et spatialement à leur gabarit. Une large partie des recherches du CAOR porte ainsi sur la reconnaissance de gestes et d’actions à partir de vidéos. Les systèmes développés sont capables d’extraire en temps réel le squelette d’un opérateur, d’identifier ses gestes et de comprendre la scène dans son ensemble. Pour dépasser les limites des approches classiques, les chercheurs mobilisent des stratégies avancées afin d’apprendre avec peu de données et de s’adapter à la variabilité des gestes humains. Certains travaux vont plus loin en cherchant à prédire les trajectoires humaines. En analysant des séries temporelles de mouvements et de forces, l’IA peut anticiper les trajectoires ou les efforts à venir. Cette capacité ouvre la voie à des robots collaboratifs plus fluides, capables d’ajuster leur comportement avant même le contact.

Données d’entraînement de mouvement.

La localisation et le SLAM (Simultaneous Localization And Mapping) constituent un autre pilier historique du CAOR. Les chercheurs combinent différentes sources d’information, comme la vision, l’inertie, le Wi-Fi ou encore le champ magnétique terrestre, afin de permettre à des robots de se localiser avec précision en intérieur, là où le GPS est inefficace.

Sur la base de ces perceptions, l’IA doit décider. Le centre développe des modèles capables de prédire les trajectoires futures des véhicules ou des usagers, un élément clé pour la planification sécurisée. Parallèlement, des travaux en apprentissage par renforcement ont permis de concevoir des pilotes automatiques performants, récompensés à l’international, capables d’apprendre des stratégies de conduite à partir de l’expérience.

Une spécificité forte du CAOR réside dans l’hybridation entre modèles physiques et apprentissage automatique. Plutôt que de remplacer les approches classiques du contrôle et de l’estimation, l’IA vient les enrichir.

Des filtres enrichis par des réseaux neuronaux, ou des approches combinant lois physiques et données, permettent d’obtenir des systèmes plus robustes, plus interprétables et souvent plus performants que les solutions purement data-driven ou basées sur la data. Cette rigueur est cruciale pour des applications critiques, comme la robotique ou les véhicules autonomes.

Ces travaux ont été mis en lumière lors du Workshop IA organisé en décembre 2025 à Mines Paris – PSL. Pensé comme un moment d’échange interne, l’événement a permis aux enseignants-chercheurs, doctorants et ingénieurs de présenter leurs projets, outils et plateformes, à travers des présentations orales et des posters.

Au-delà de la diversité des sujets, le workshop a souligné une dynamique commune : construire une IA ancrée dans le réel, capable de dialoguer avec les humains et de s’intégrer dans des systèmes complexes.

En perspective, les chercheurs du CAOR s’intéressent à l’intégration en robotique des grands modèles de fondation, un modèle d’intelligence artificielle de grande taille, entraîné sur une grande quantité de données. L’objectif : développer des IA plus générales, capables de comprendre des situations nouvelles et d’apprendre rapidement de nouvelles actions.

À travers ces recherches, le Centre de Robotique de Mines Paris – PSL affirme une vision claire : une intelligence artificielle qui ne se contente pas de reconnaître ou de prédire, mais qui perçoit, comprend et agit, dans diverses applications pratiques.

Le dernier film « Mission: Impossible – Dead Reckoning » tire son nom d’une méthode de navigation consistant à estimer sa position actuelle en se basa...