Une IA fiable, sobre et explicable : l’étude de ses fondements mathématiques au CMA

Les recherches menées au CMA s’inscrivent dans une conviction forte : l’IA ne peut se limiter à l’accumulation de données et de paramètres. Pour être fiable, interprétable et réellement utile, elle doit s’appuyer sur des modèles mathématiques explicites.

C’est dans cet esprit que s’inscrit l’une des chaires PR[AI]RIE-PSAI (PaRis Artificial Intelligence Research InstitutE – Paris School of IA) portée par Jesus G. Angulo au CMA. Créée en 2019 par notre Université PSL ainsi que le CNRS, l’Inria, l’Institut Pasteur, l’Université Paris Cité et un groupe de partenaires industriels, PR[AI]RIE est l’un des quatre instituts interdisciplinaires de recherche en IA mis en place dans le cadre de la stratégie nationale pour l’IA annoncée par le président de la République en 2018. PR[AI]RIE-PSAI a pour objectif de devenir un leader mondial dans la recherche et l’enseignement supérieur en IA, avec un impact réel sur l’économie et la société.

Au sein de la chaire PR[AI]RIE-PSAI de J. G. Angulo, la morphologie mathématique fournit un langage commun pour décrire des formes, des structures et des relations spatiales complexes. Elle permet de formaliser des notions telles que la géométrie des données, leur topologie ou leur variabilité, là où les approches purement statistiques atteignent leurs limites.

Le contexte et l’objectif de la chaire est de combiner la puissance des réseaux de neurones (convolutifs ou transformers) avec des méthodes mathématiques rigoureuses de traitement d’image/données. En travaillant sur un socle théorique non-linéaire commun issu de la morphologie mathématique, certains paradigmes sont intégrés dans les réseaux de neurones :

Un autre axe majeur au CMA concerne l’hybridation entre apprentissage automatique, ou machine learning, et optimisation mathématique. Ces recherches, portées notamment par Sophie Demassey, trouvent leur application dans de nombreux systèmes industriels : réseaux d’eau potable, gestion de l’énergie, stockage… Dans ces domaines, les décisions doivent respecter des contraintes strictes : capacités physiques, règles de sécurité ou encore coûts énergétiques. Or, si les modèles d’apprentissage profond, ou deep learning, sont efficaces pour prédire des comportements à partir de données historiques, ils ne garantissent ni la faisabilité ni l’optimalité des décisions proposées.

La solution développée au CMA consiste à faire dialoguer prédiction et optimisation. Dans le cas de la gestion énergétique de réseaux d’eau, un réseau de neurones apprend à prédire des profils de stockage plausibles à partir des données passées. Ces prédictions servent ensuite de point de départ à un algorithme d’optimisation combinatoire, chargé de corriger et certifier la bonne solution.

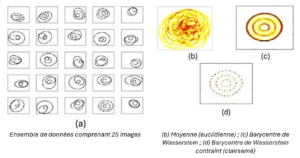

Un autre défi central de l’IA moderne est la gestion de données complexes telles que les images, les nuages de points ou encore les distributions de probabilités. Welington de Oliveira travaille sur une notion clé pour ces problématiques : le transport optimal. Chaque donnée est comme une pile de sable. Au lieu de comparer simplement deux piles, le transport optimal mesure l’effort minimal nécessaire pour transformer une pile en une autre, comme si on déplaçait le sable de manière optimale.

Pour quantifier cet effort, on utilise la distance de Wasserstein, qui évalue à quel point deux ensembles de données sont proches ou éloignés, même s’ils sont très complexes. Si vous avez plusieurs photos de chats, le transport optimal permet de calculer une image moyenne qui représente au mieux l’ensemble de ces photos. Cette image moyenne, appelée barycentre de Wasserstein, est une sorte de « portrait-robot » des chats photographiés.

Grâce aux travaux du CMA, il est désormais possible d’intégrer des règles supplémentaires lors du calcul de cette moyenne. Par exemple, on peut imposer de ne garder que les informations les plus importantes (sparsité), ou encore forcer le résultat à respecter une certaine structure pour qu’il reste réaliste. Grâce à des méthodes d’optimisation performantes, ces calculs deviennent possibles même pour des ensembles de données très volumineux.

Ces avancées permettent de développer des algorithmes plus robustes, capables de synthétiser et d’analyser des données complexes avec une grande précision. Les applications sont nombreuses : amélioration du traitement d’images, classification automatique d’objets, ou encore analyse de données rares ou incomplètes, comme des images médicales ou des relevés scientifiques. En somme, ces travaux aident l’IA à mieux appréhender la complexité du monde réel, pour des résultats plus fiables et utiles dans notre quotidien.

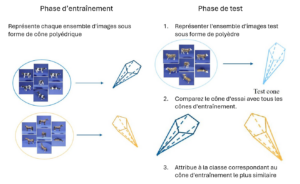

Dans certains domaines comme l’étude des maladies rares, la reconnaissance d’objets uniques ou l’écologie, les données disponibles sont souvent très limitées. Or, les méthodes traditionnelles d’IA peinent à fonctionner efficacement dans ces conditions, où l’on parle de Few-Shot Learning, un domaine qui consiste à apprendre à partir de très peu d’exemples.

Valentina Sessa et ses collègues ont développé une approche originale pour surmonter ce problème. Au lieu de représenter des ensembles d’images comme des espaces linéaires classiques, ils les modélisent sous la forme de cônes convexes, des structures géométriques mieux adaptées pour capturer la diversité et les variations des données. Pour comparer ces ensembles, ils ont mis au point une nouvelle mesure de dissimilarité, basée sur les angles maximaux et minimaux entre ces cônes.

Cette mesure est liée à une distance mathématique appelée distance de Pompeiu-Hausdorff, qui permet d’évaluer plus finement les différences entre les groupes d’images. Cette méthode repose sur des algorithmes d’optimisation non convexes, conçus pour garantir des calculs fiables même dans des situations complexes. Grâce à cette innovation, il devient possible de mieux distinguer des catégories différentes même avec très peu d’exemples à disposition.

L’impact est significatif : cette approche améliore les performances de l’IA dans des contextes où les données sont rares, difficiles ou coûteuses à obtenir, comme le diagnostic de maladies peu fréquentes ou l’identification d’espèces animales à partir de quelques observations. Elle ouvre ainsi la voie à des applications plus précises et plus robustes, même lorsque les informations disponibles sont limitées.

Ces travaux ont été mis en lumière lors du Workshop IA organisé en décembre 2025 à Mines Paris – PSL. Pensé comme un moment d’échange interne, l’événement a permis aux enseignants-chercheurs, doctorants et ingénieurs de présenter leurs projets, outils et plateformes, à travers des présentations orales et des posters.

Au-delà de la diversité des sujets, le workshop a souligné une dynamique commune : construire une IA ancrée dans le réel, capable de dialoguer avec les humains et de s’intégrer dans des systèmes complexes.

Au-delà des résultats techniques, les recherches en IA du CMA partagent une ambition commune : développer une intelligence artificielle plus raisonnable, au sens du rapport entre moyens et besoins.

Face à la course aux modèles toujours plus volumineux et énergivores, les mathématiques offrent une alternative :

Cette approche s’inscrit pleinement dans une démarche de sobriété numérique et de conception responsable, en phase avec les enjeux de transition écologique et industrielle.

Au CMA, l’IA n’est pas seulement une technologie : c’est un objet scientifique à part entière. En l’ancrant dans des cadres mathématiques solides, les chercheurs du centre contribuent à dessiner une IA plus fiable, plus compréhensible et plus durable, une IA pensée pour répondre aux défis réels de notre société.

Des grands modèles de langage capables d’analyser des centaines de milliers de pages aux supercalculateurs qui consomment l’électricité d’une petite v...